In un articolo recentemente pubblicato su Biologia PLoSI ricercatori hanno ricostruito un brano musicale da registrazioni neurali utilizzando modelli computazionali mentre studiavano le dinamiche neurali spaziali che sono alla base della percezione musicale utilizzando modelli di codifica e analisi di ablazione.

Soggiorno: La musica può essere ricostruita dall’attività della corteccia uditiva umana utilizzando modelli di decodificazione non lineare. Credito immagine: LianLeonte/Shutterstock

sfondo

La musica, un’esperienza umana universale, attiva molte delle stesse aree cerebrali della parola. I ricercatori di neuroscienze hanno seguito le basi neurali della percezione musicale per molti anni e hanno identificato correlati neurali distinti degli elementi musicali, tra cui timbro, melodia, armonia, intonazione e ritmo. Tuttavia, non è ancora chiaro come queste reti neurali interagiscano per elaborare la complessità della musica.

“Una cosa per me della musica è che ha prosodia (ritmi e toni) e contenuto emotivo. Con l’avanzare del campo delle interfacce cervello-macchina, questa ricerca potrebbe aiutare ad aggiungere musicalità ai futuri impianti cerebrali per le persone con disabilità”, spiega. Disturbi neurologici o dello sviluppo che influenzano il linguaggio”.

-medico. Robert Knight, Università della California, Berkeley

A proposito dello studio

Nel presente studio, i ricercatori hanno utilizzato la ricostruzione dello stimolo per esaminare come il cervello elabora la musica. Hanno impiantato 2.668 elettrodi per elettrocorticografia (ECoG) su 29 superfici corticali di un paziente neurochirurgico (il cervello) per registrare l’attività neurale o raccogliere dati elettroencefalografici (iEEG) mentre ascoltavano passivamente un estratto di tre minuti della canzone dei Pink Floyd: “Another Brick”. Nel muro, prima parte.

L’uso dell’ascolto passivo come metodo di presentazione dello stimolo previene la confusione tra l’elaborazione neurale della musica e l’attività motoria e il processo decisionale.

Sulla base dei dati degli elettrodi 347/2668, hanno ricostruito la canzone, che somigliava molto alla canzone originale, anche se con meno dettagli: ad esempio, le parole nella canzone ricostruita erano molto meno chiare. Nello specifico, hanno utilizzato modelli di decodifica basati sulla regressione per ricostruire accuratamente questo stimolo uditivo (in questo caso, un brano musicale di tre minuti) dall’attività neurale.

In passato, i ricercatori hanno utilizzato metodi simili per ricostruire il parlato a partire dall’attività cerebrale; Tuttavia, questa è la prima volta che tentano di ricostruire la musica utilizzando un simile approccio.

iEEG ha un’elevata risoluzione temporale e un eccellente rapporto segnale-rumore. Fornisce accesso diretto all’attività ad alta frequenza (HFA), un indicatore di attività neurale non oscillatoria che riflette l’elaborazione locale delle informazioni.

Allo stesso modo, i modelli non lineari di decodifica dalla corteccia uditiva e sensomotoria hanno fornito la massima precisione di decodifica e una notevole capacità di ricostruire il parlato intelligibile. Pertanto, il team ha combinato iEEG e modelli di decodifica non lineare per rivelare le dinamiche neurali alla base della percezione musicale.

Il team ha inoltre misurato l’effetto della durata del set di dati e della densità degli elettrodi sull’accuratezza della ricostruzione.

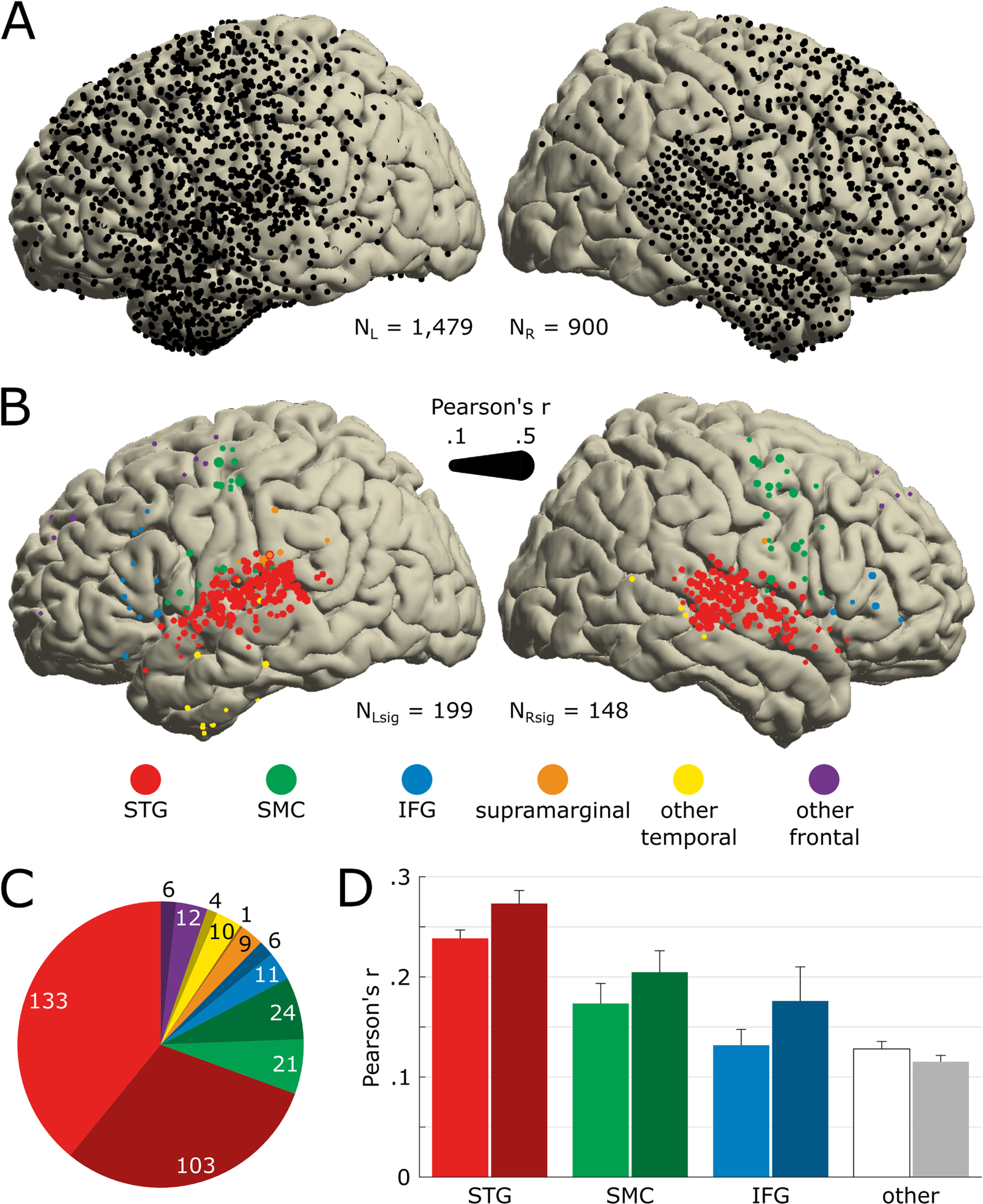

Posizione anatomica degli elettrodi sensibili al canto.UN) Copertura degli elettrodi per tutti i 29 pazienti mostrati sul modello MNI (n=2379). Tutti gli elettrodi forniti sono esenti da qualsiasi attività artificiale o epilettica. L’emisfero sinistro è disegnato a sinistra. (B) Posizione degli elettrodi che codificano in modo significativo l’acustica della canzone (NSaggio = 347). Il significato è stato determinato dall’accuratezza delle previsioni STRF bootstrap su 250 campioni provenienti dai set di training, validazione e test. Il colore del marcatore indica la nomenclatura anatomica determinata utilizzando l’atlante FreeSurfer e la dimensione del marcatore indica l’accuratezza delle previsioni STRF (coefficiente di Pearson tra HFA effettivo e previsto). Utilizziamo lo stesso codice colore nei seguenti pannelli e figure. (C) Numero di elettrodi significativi per regione anatomica. Il colore scuro indica la posizione dell’emisfero destro. (Dott.) Precisione media della previsione STRF per ciascuna regione anatomica. Gli elettrodi precedentemente classificati come sopramarginali, altri elettrodi temporali (cioè diversi da STG) e altri elettrodi frontali (cioè diversi da SMC o IFG) sono raggruppati insieme, etichettati come altri e sono rappresentati in bianco/grigio. Le barre di errore indicano SEM. I dati dietro questo numero possono essere trovati su https://doi.org/10.5281/zenodo.7876019. HFA, attività ad alta frequenza; IFG, giro frontale inferiore. MNI, Istituto neurologico di Montreal; SEM, errore standard della media; SMC, corteccia sensomotoria. STG, giro temporale superiore; STRF sta per Campo Ricettivo Temporale Spettrale.https://doi.org/10.1371/journal.pbio.3002176.g002

risultati

I risultati dello studio hanno mostrato che entrambi gli emisferi del cervello sono coinvolti nell’elaborazione della musica, con il giro temporale superiore (STG) nell’emisfero destro che gioca un ruolo più importante nella percezione della musica. Inoltre, sebbene i lobi temporali e frontali fossero attivi durante la percezione della musica, la nuova sottoregione STG era sintonizzata sul ritmo musicale.

I dati provenienti da 347 dei quasi 2.700 elettrodi ECoG hanno aiutato i ricercatori a scoprire la codifica musicale. I dati hanno mostrato che entrambi gli emisferi del cervello erano coinvolti nell’elaborazione della musica, con gli elettrodi nell’emisfero destro che rispondevano più attivamente alla musica rispetto all’emisfero sinistro (16,4% contro 13,5%), un risultato in diretto contrasto con il parlato. Vale la pena notare che il parlato suscita risposte più importanti nell’emisfero sinistro del cervello.

Tuttavia, in entrambi gli emisferi, la maggior parte degli elettrodi sensibili alla musica sono stati impiantati in un’area chiamata giro temporale superiore (STG), suggerendo che probabilmente hanno svolto un ruolo cruciale nella percezione della musica. L’STG si trova appena sopra e dietro l’orecchio.

Inoltre, i risultati dello studio hanno mostrato che i modelli non lineari fornivano la massima precisione di decodifica, r-quadrato, pari al 42,9%. Tuttavia, l’aggiunta di elettrodi oltre una certa quantità riduce anche la precisione della decodifica; Pertanto, la rimozione dei 43 elettrodi del ritmo corretto ha ridotto la precisione della decodifica.

Gli elettrodi inclusi nel modello di decodifica avevano caratteristiche funzionali e anatomiche uniche, che influivano anche sulla precisione di decodifica del modello.

Infine, per quanto riguarda l’effetto della durata del set di dati sulla precisione di decodifica, gli autori notano che il modello ha raggiunto l’80% della precisione di decodifica massima osservata a 37 secondi. Questo risultato sottolinea l’uso di metodi di modellazione predittiva (come utilizzati in questo studio) in piccoli set di dati.

I dati dello studio potrebbero avere implicazioni per le applicazioni di interfaccia cervello-computer (BCI), ad esempio, strumenti di comunicazione per persone con disabilità che hanno problemi di linguaggio. Poiché la tecnologia BCI è relativamente nuova, le interfacce disponibili basate su BCI generano un parlato con una qualità innaturale e robotica, che può migliorare con l’incorporazione di elementi musicali. Inoltre, i risultati dello studio potrebbero essere clinicamente rilevanti per i pazienti con disturbi dell’elaborazione uditiva.

Conclusione

I nostri risultati confermano ed estendono i risultati precedenti sulla percezione della musica, inclusa la dipendenza della percezione della musica da una rete bilaterale con il lato destro. All’interno della distribuzione spaziale delle informazioni musicali, componenti ridondanti e unici sono stati distribuiti tra STG, giro temporale medio (SMC) e giro frontale inferiore (IFG) nell’emisfero sinistro e concentrati rispettivamente nell’STG nell’emisfero destro.

La ricerca futura potrebbe mirare ad espandere la copertura degli elettrodi ad altre aree corticali, modificare le caratteristiche dei modelli di decodifica non lineare e persino aggiungere una dimensione comportamentale.

“Organizzatore. Fanatico di zombi. Specialista del caffè. Appassionato di Twitter certificato. Secchione amichevole dell’alcol. Introverso. Difensore del cibo.”

More Stories

'The Fall Guy' decolla al botteghino estivo dopo una primavera difficile

Taylor Swift si è presa una cotta per Travis Kelce mentre gridava di nuovo “Viva Las Vegas” al concerto di Patrick Mahomes: il lettore labiale rivela la reazione rabbiosa della pop star in un video virale

La cantante FKA Twigs afferma di aver sviluppato la propria tecnologia deepfake durante un'udienza al Senato