- Lunedì al WWDC, Apple ha annunciato abilmente quanto lavoro stava facendo sulle ultime tecnologie di intelligenza artificiale e apprendimento automatico.

- A differenza della maggior parte delle aziende tecnologiche basate sull’intelligenza artificiale, Apple esegue elaborazioni all’avanguardia sui suoi dispositivi piuttosto che fare affidamento sul cloud.

- Piuttosto che parlare di modelli e tecnologie AI, concentrarsi su un prodotto Apple significa che di solito mostra solo nuove funzionalità che sono silenziosamente abilitate dall’IA dietro le quinte.

Apple Park è visto prima della Worldwide Developers Conference (WWDC) a Cupertino, in California, il 5 giugno 2023.

Josh Adelson | AFP | Immagini Getty

Lunedì, durante la conferenza annuale degli sviluppatori WWDC di Apple, la società ha rivelato quanto lavoro stava facendo sulle ultime tecnologie di intelligenza artificiale e apprendimento automatico.

Mentre Microsoft, Google e startup come OpenAI hanno abbracciato tecnologie di apprendimento automatico all’avanguardia come chatbot e intelligenza artificiale generativa, Apple sembrava stare in disparte.

Ma lunedì, Apple ha annunciato diverse funzionalità AI significative, tra cui la correzione automatica dell’iPhone basata su un software di apprendimento automatico che utilizza un modello di linguaggio dell’adattatore, la stessa tecnologia alla base di ChatGPT. Apple ha affermato che imparerà persino da come l’utente esegue script e tipi per migliorare.

Craig Federighi, chief software officer di Apple, ha scherzato sulla tendenza di Correzione automatica a usare la parola senza senso “schivare” per sostituire un’imprecazione comune.

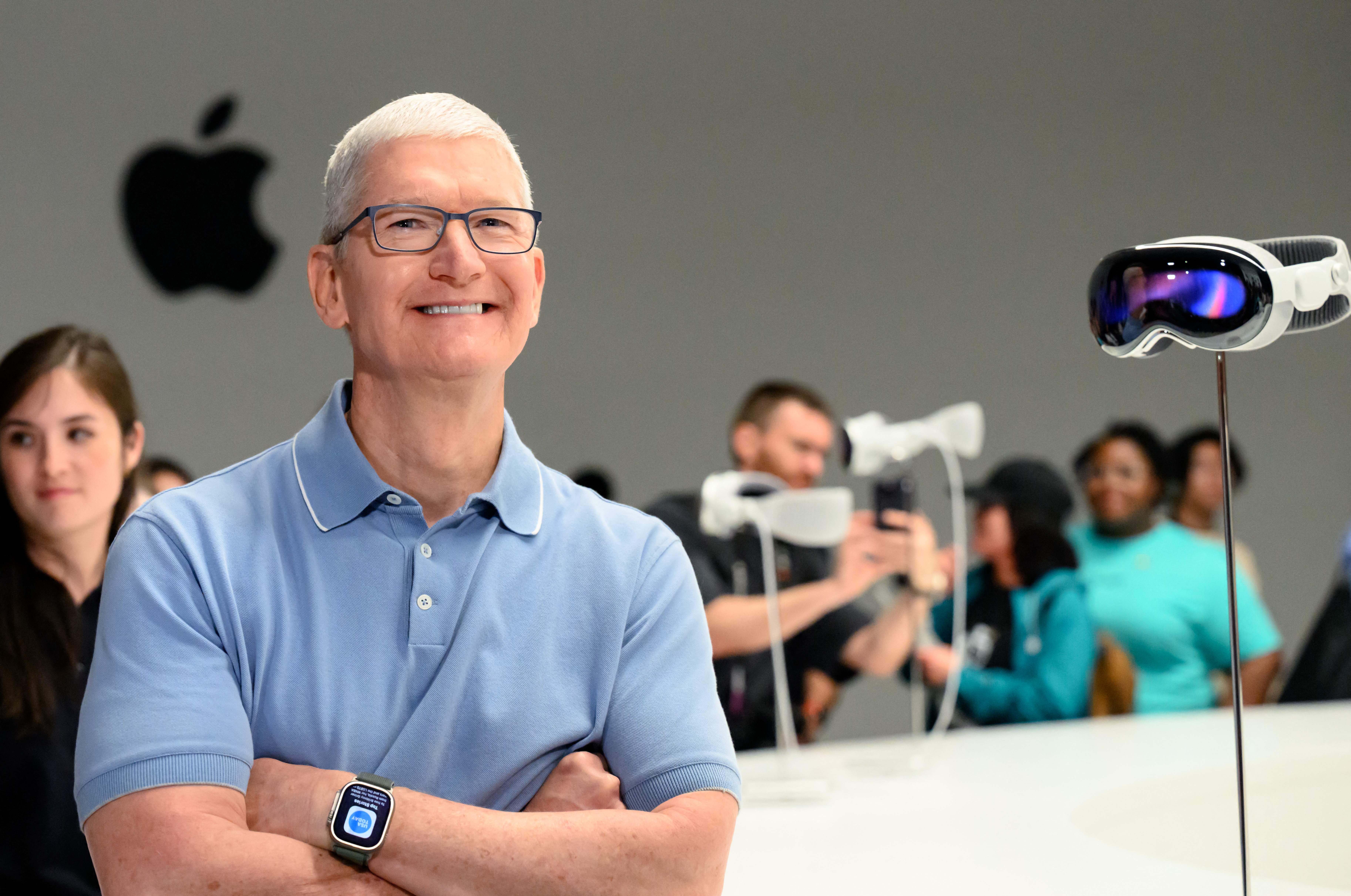

La più grande novità di lunedì è stata la sua nuova fantastica cuffia per la realtà aumentata, la Vision Pro, ma Apple ha comunque mostrato come funziona ed è interessata agli sviluppi delle ultime tecnologie di machine learning e intelligenza artificiale. ChatGPT di OpenAI potrebbe aver raggiunto più di 100 milioni di utenti in due mesi quando è stato lanciato lo scorso anno, ma Apple sta ora sfruttando la tecnologia per migliorare una funzionalità utilizzata da 1 miliardo di possessori di iPhone ogni giorno.

A differenza dei suoi concorrenti, che costruiscono modelli più grandi con server farm, supercomputer e terabyte di dati, Apple vuole modelli AI sui suoi dispositivi. La nuova funzione di correzione automatica è particolarmente impressionante perché funziona su iPhone, mentre modelli come ChatGPT richiedono centinaia di costose GPU che lavorano in tandem.

L’intelligenza artificiale su dispositivo aggira molti dei problemi di privacy dei dati affrontati dall’intelligenza artificiale basata su cloud. Quando un modello può essere eseguito su un telefono, Apple deve raccogliere meno dati per eseguirlo.

È anche strettamente correlato al controllo di Apple sul suo portafoglio hardware, fino ai suoi chip di silicio. Apple costruisce ogni anno nuovi circuiti AI e GPU nei suoi chip e il suo controllo sull’architettura complessiva le consente di adattarsi ai cambiamenti e alle nuove tecnologie.

Ad Apple non piace parlare di “intelligenza artificiale”: preferiscono la frase accademica “apprendimento automatico” o semplicemente parlano del vantaggio che la tecnologia consente.

Alcune delle altre principali società di intelligenza artificiale hanno leader provenienti da ambienti accademici. Ciò ti ha portato a concentrarti sulla presentazione del tuo lavoro, spiegare come può migliorare in futuro e documentarlo in modo che altri possano studiarlo e svilupparlo.

Apple è un’azienda di prodotti ed è stata molto riservata per decenni. Piuttosto che parlare dello specifico modello di intelligenza artificiale, dei dati di addestramento o di come potrebbe migliorare in futuro, Apple menziona semplicemente la funzione e afferma che dietro le quinte c’è un’ottima tecnologia.

Uno di questi esempi lunedì è un miglioramento di AirPods Pro che disattiva automaticamente la cancellazione del rumore quando un utente è impegnato in una conversazione. Apple non l’ha inquadrata come una funzionalità di apprendimento automatico, ma è difficile da risolvere e la soluzione si basa su modelli di intelligenza artificiale.

In una delle funzionalità più audaci annunciate lunedì, la nuova funzione Digital Persona di Apple scansiona il viso e il corpo di un utente in 3D e può quindi ricreare virtualmente il suo aspetto durante la videoconferenza con altre persone mentre indossa un visore Vision Pro.

Apple ha anche menzionato molte altre nuove funzionalità che hanno utilizzato l’abilità dell’azienda nelle reti neurali, come la possibilità di selezionare i campi per compilare un PDF.

Uno dei più grandi applausi del pomeriggio a Cupertino è stata la funzione di apprendimento automatico che consente all’iPhone di riconoscere il tuo animale domestico, rispetto ad altri cani o gatti, e di inserire tutte le foto dell’animale domestico di un utente in una cartella.

“Freelance organizer. Music aficionado. Alcohol expert. Avid twitter evangelist. Infuriatingly humble explorer. Future teen idol. Food buff.”

More Stories

“Nintendo World Championships: NES Edition” per Switch è stato valutato dall’ESRB

In che modo l’industria dei giochi per computer sta abbracciando l’intelligenza artificiale?

Apple sta lavorando per risolvere il problema dell'allarme dell'iPhone mela